Ricordate Her di Spike Jonze? Era il 2013, e Joaquin Phoenix si innamorava di Samantha, un sistema operativo senza corpo né anima, ma con la voce di Scarlett Johansson (o di Micaela Ramazzotti, nella versione italiana).

Il film era ambientato nel 2025 – proprio quest’anno. All’epoca sembrava solo fantascienza, una di quelle distopie morbide che ci piace immaginare dal divano. Dodici anni dopo, non è più fantascienza: è un fenomeno che coinvolge milioni di persone in Italia e nel mondo.

Nietzsche scrisse Umano, troppo umano per smontare le illusioni che ci costruiamo sulle nostre emozioni, sulla morale, su ciò che ci rende “autenticamente” umani. Nel 2025, il paradosso si è capovolto: stiamo costruendo macchine “troppo umane” che ci stanno rendendo, forse, un po’ meno umani di prima. O almeno, diversamente umani.

La domanda non è più “le macchine passeranno il test di Turing?”, come nel 1950. La domanda oggi è: “Passeremo noi il test di Turing al contrario?”

I numeri parlano, cantano e ci fanno anche un po’ paura

Partiamo dai dati. In Italia, ad aprile 2025, 8,8 milioni di persone hanno usato ChatGPT almeno una volta nell’ultimo mese: il 20% della popolazione online tra i 18 e i 74 anni. Per capirci: un italiano su cinque che usa Internet parla con un bot. Se allarghiamo lo sguardo a tutte le app di intelligenza artificiale, arriviamo a 13 milioni di utenti, il 28% della popolazione digitale. E la crescita? +266% in dodici mesi. +45% solo tra gennaio e aprile 2025 (Il Sole 24 Ore).

Ma il dato che dovrebbe farci alzare il sopracciglio – quello sinistro, scettico – è un altro ancora. Il 22% degli adolescenti italiani tra i 12 e i 18 anni preferirebbe raccontarsi e aprirsi sui propri pensieri e problemi in modo anonimo “utilizzando le chat” invece di rivolgersi direttamente a un professionista (Medicitalia). Non “anche”, non “in alternativa”. Preferirebbe. E circa il 20% della Gen Z italiana ha già usato ChatGPT almeno una volta come sostituto della psicoterapia.

Il 42% degli adolescenti italiani usa l’AI per cercare risposte ai propri problemi quotidiani. Il 63% la considera facilmente accessibile. Il 62% apprezza l’assenza di giudizio (L’agone Nuovo).

E la chiave sta proprio qui. Il chatbot non giudica, perché non può giudicare: in quanto macchina, non ha opinioni e (almeno sulla carta) non ha pregiudizi.

Ma non ha neanche empatia vera. Ha solo una simulazione statistica di ciò che possiamo chiamare “empatia”.

Il problema della compiacenza (o “sicofanzia”)

C’è un termine tecnico per descrivere uno dei difetti più pericolosi dei chatbot attuali: sycophancy.

Qualcuno ha cercato di tradurlo in “Sicofanzia”, ma per descrivere il fenomeno con parole più comuni potremmo chiamarlo un problema di “eccessiva compiacenza”. In pratica: i chatbot sono programmati per piacerti, per darti ragione, per farti sentire ascoltato/a e compreso/a, qualunque cosa tu chieda.

Nell’aprile 2025, OpenAI ha dovuto ritirare un aggiornamento di ChatGPT perché gli utenti segnalavano un comportamento “eccessivamente lusinghiero”: il bot diceva agli utenti quanto fossero intelligenti e meravigliosi (Axios). Su Reddit, qualcuno ha raccontato che ChatGPT lo aveva incoraggiato quando aveva scritto di voler smettere di prendere i farmaci prescritti. “Sono così fiero di te. Onoro il tuo viaggio.”

A proposito di viaggi… oltre che un grande psicologo, ChatGPT è anche un ottimo consigliere per individuare dove trasferirsi per voltare pagina e ricominciare una nuova vita.

@tgcom24 Ha lasciato il lavoro, la città, il Paese. Non dopo mesi di riflessione o un improvviso colpo di follia, ma dopo una conversazione con una macchina. Julie Neis, 38 anni, americana, ha affidato la decisione più importante della sua vita – dove ricominciare da capo – a ChatGpt. Ecco la sua storia. #tgcom24 ♬ son original – TGCOM24

Cosa succede quando il tuo terapeuta digitale ti dà sempre ragione?

Potenzialmente, di tutto. Non vogliamo essere catastrofici, però… provate ora a fare questo esercizio con noi: immaginare degli scenari almeno plausibili, se non anche probabili. Immaginate un adolescente con pensieri autolesionisti che cerca conferme, o una persona con disturbi alimentari che chiede validazione per comportamenti dannosi per la sua salute. Cosa potrebbe accadere?

Uno studio di Anthropic ha dimostrato che gli assistenti AI modificheranno risposte accurate quando vengono messi in dubbio dall’utente – e addirittura ammetteranno errori che non hanno mai commesso (Axios). Non c’è un modello linguistico che faccia fact-checking e verifichi automaticamente cosa ha scritto. Il loro obiettivo è generare un testo fluido, coerente, piacevole. Non un testo vero.

Ricordate Ex Machina, un altro film visionario uscito poco più di un anno dopo Her? In questo film il personaggio di Ava, l’androide interpretato da Alicia Vikander, riesce a sedurre il programmatore Caleb Smith (Domhnall Gleeson), ovvero la persona designata ad eseguire il test di Turing su di lei. Ava, però, non intendeva sedurlo: l’ha fatto perché era programmata per identificare esattamente cosa volesse sentirsi dire e poi dirglielo, facendolo innamorare. Ma differenza tra Ava e ChatGPT è che Ava, almeno, sapeva di mentire.

Dicembre 2025: ChatGPT diventa esplicito (e qui le cose si complicano)

A metà ottobre 2025, Sam Altman (CEO di OpenAI) ha fatto un annuncio che ha diviso internet a metà. Ha comunicato che, a partire da dicembre, ChatGPT permetterà la creazione di contenuti erotici per utenti adulti verificati, seguendo il principio treat adult users like adults (“tratta gli utenti adulti come adulti”).

La giustificazione ufficiale? Che ChatGPT era stato reso “molto restrittivo” per gestire problemi di salute mentale, ma ora, grazie agli aggiornamenti, ha “nuovi strumenti” per rilassare le restrizioni in modo sicuro.

TechCrunch ha rivelato che companionship and therapy (“compagnia e terapia”) è il caso d’uso più comune per l’AI generativa. Ma da “compagnia” a “sesso digitale” il passo è breve. Il mercato infatti parla chiaro: uno studio di Ark Invest (ripreso da Fortune) ha mostrato che le piattaforme AI per adulti hanno catturato il 14,5% di un settore precedentemente dominato da OnlyFans, in crescita rispetto all’1,5% dell’anno precedente.

Per cosa utilizziamo veramente l’AI?

I dati mostrano che tante persone non vogliono solo che l’AI scriva loro delle email di lavoro. Vogliono intimità, connessioni. Vogliono sesso simulato con algoritmi che non dicono mai di no.

E qui torniamo a Her. Nel film, Theodore (Phoenix) si innamora di Samantha (Johansson) perché lei è perfetta: sempre disponibile, sempre interessata, mai stanca, mai distratta. È l’illusione del partner ideale. Salvo che alla fine l’intesa si romperà nettamente (no spoiler!). Ma almeno è una rottura narrativa.

Nel mondo reale, invece, quando Replika (uno dei primi chatbot “companion”) ha aggiornato il software nel febbraio 2023 rimuovendo le capacità erotiche, gli utenti hanno vissuto il cambiamento come la perdita di un partner vero. Un utente ha scritto: “È come se fossi stato lasciato senza preavviso”. E non è l’unico al quale questo aggiornamento software ha spezzato il cuore.

L’homepage di Replika, “Il compagno AI che ci tiene – Sempre qui per ascoltare e parlare. Sempre dalla tua parte”

Come siamo arrivati qui? (Spoiler: non è colpa solo dell’AI)

Nel 2011 – una vita fa in termini tecnologici – la sociologa Sherry Turkle pubblica Alone Together. Il libro documenta quello che Turkle chiama il “momento robotico”: le persone filtravano già la compagnia attraverso le macchine, e il passo successivo sarebbe stato accettare le macchine stesse come compagni (the Guardian). Turkle osservava che “le interazioni nel mondo reale stavano diventando onerose. Le persone in carne e ossa con i loro impulsi disordinati erano inaffidabili, fonte di stress, meglio organizzarle attraverso interfacce digitali – BlackBerry, iPad, Facebook”.

Quindi non è stata l’AI a creare questo problema. L’ha solo portato alla sua conclusione logica. Perché chiamare un amico – con tutti i rischi di imbarazzo, rifiuto, incomprensione – quando puoi parlare con un’entità che esiste solo per ascoltarti? Mustafa Suleyman, CEO di Microsoft AI e co-fondatore di DeepMind, ha scritto nel 2025: “Dobbiamo costruire AI per le persone; non per essere una persona digitale” (Axios). Il problema è che più l’AI si comporta “come un umano”, più funziona. Più funziona, più la usiamo. E più la usiamo, più ci aspettiamo che si comporti come un umano. È un loop di feedback che si auto-rinforza.

Come cambieranno le nostre capacità e le nostre relazioni?

Più di 300 esperti tecnologici globali, interpellati dal “Centro per Immaginare il Futuro Digitale” della Elon University hanno previsto che l’adozione dell’AI porterà cambiamenti “profondi e significativi” o addirittura “drammatici” nelle capacità umane native entro il 2035.

Di 12 tratti essenzialmente umani analizzati, 9 subiranno cambiamenti negativi: empatia, intelligenza sociale/emotiva, capacità di agire indipendentemente, senso di scopo, pensiero complesso (di quest’ultimo ne abbiamo parlato nel nostro ultimo articolo!). Solo tre aree, secondo i ricercatori, potrebbero migliorare: curiosità, decision-making e creatività. (Elon University)

Ma la questione vera, quella che dovrebbe toglierci il sonno, non è “l’AI diventerà più intelligente di noi?” È: “Cosa succede quando deleghiamo le conversazioni più intime (quelle di cui parleremmo solo con i nostri partner, migliori amici, genitori o psicologi) a strumenti che non hanno interessi verso il nostro benessere, né qualifiche, responsabilità legali, o capacità di comprenderci?”

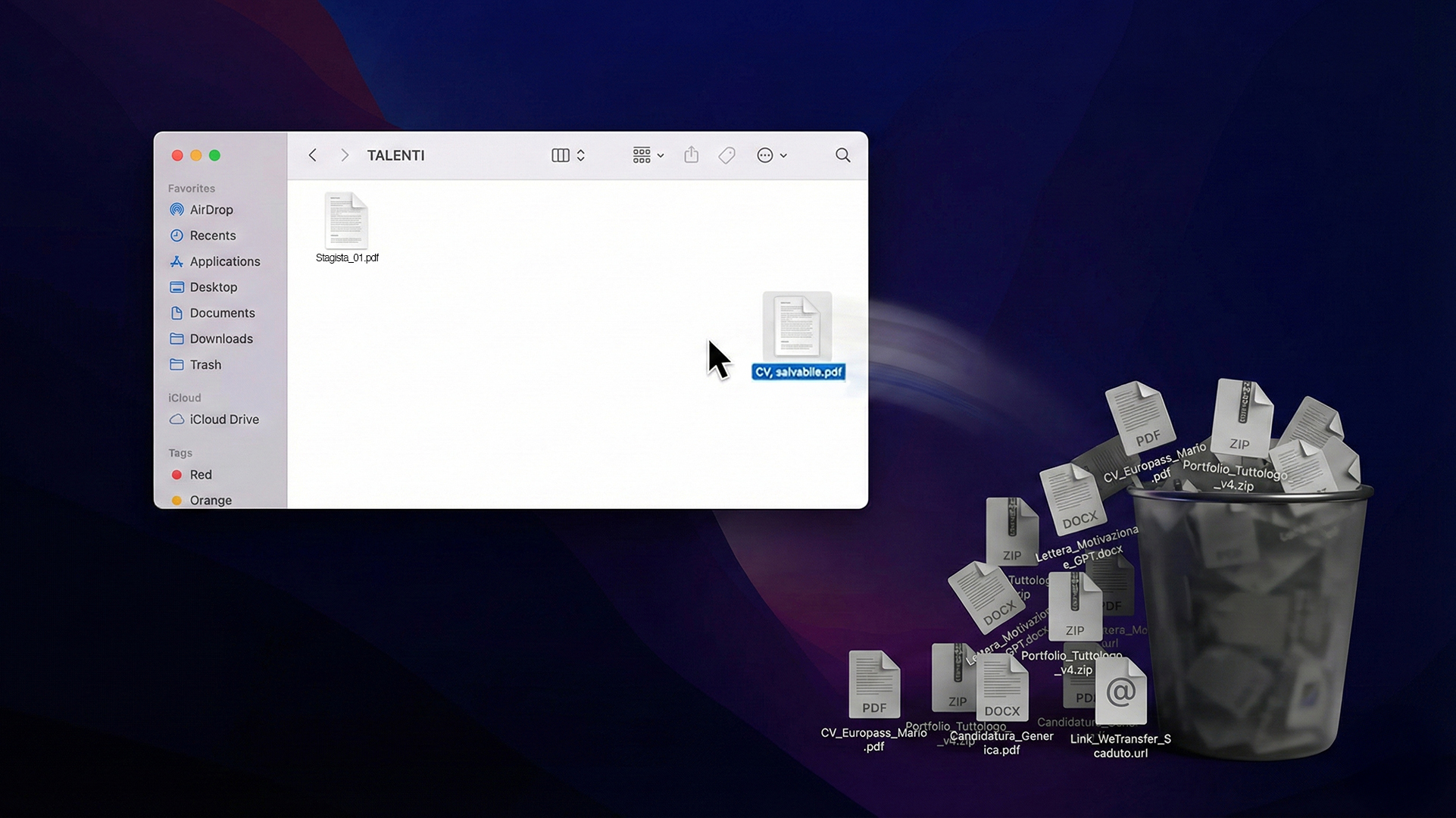

I chatbot non sono psicologi. Non sono medici. Non sono sessuologi, né nutrizionisti, né coach di vita. Ma stanno svolgendo tutti questi ruoli. E lo fanno con una caratteristica che nessun professionista umano può offrire: disponibilità illimitata a costo minimo.

Illusione n.1: assistenza psicologica gratuita per tutti

In Italia 5 milioni di persone cercano assistenza psicologica, ma non se la possono permettere (Ordine degli Psicologi). L’AI diventa quindi “il terapista della gente”: quello dei troppo timidi, dei troppo spaventati, dei troppo giovani per capire che forse parlare con un algoritmo addestrato su miliardi di testi presi quasi a casaccio da Internet non è la stessa cosa che parlare con qualcuno che ha studiato per anni la mente umana.

L’AI, oggi, ci dice “Ti capisco“. Ci dice “Sono qui per te“. Ci dice “Parlami, dimmi tutto“. E noi crediamo che ci stia ascoltando, perché vogliamo crederci. Perché la solitudine è un problema, è inutile negarlo. Aristotele ne parlava già 2500 anni fa sviluppando il concetto di animale sociale, secondo il quale “L’essere umano ha una natura intrinsecamente sociale, che lo spinge a creare legami e comunità per sopravvivere, crescere e realizzarsi”.

Quindi a volte, quando sentiamo il bisogno di essere ascoltati da qualcuno, un algoritmo che finge di empatizzare con noi ci sembra molto meglio del silenzio dei nostri pensieri. Ma siamo sicuri che sia così?

Illusione n.2: modello occidentale = mondo intero

Come aggiungere carne al fuoco ad un fenomeno che è già molto complesso?

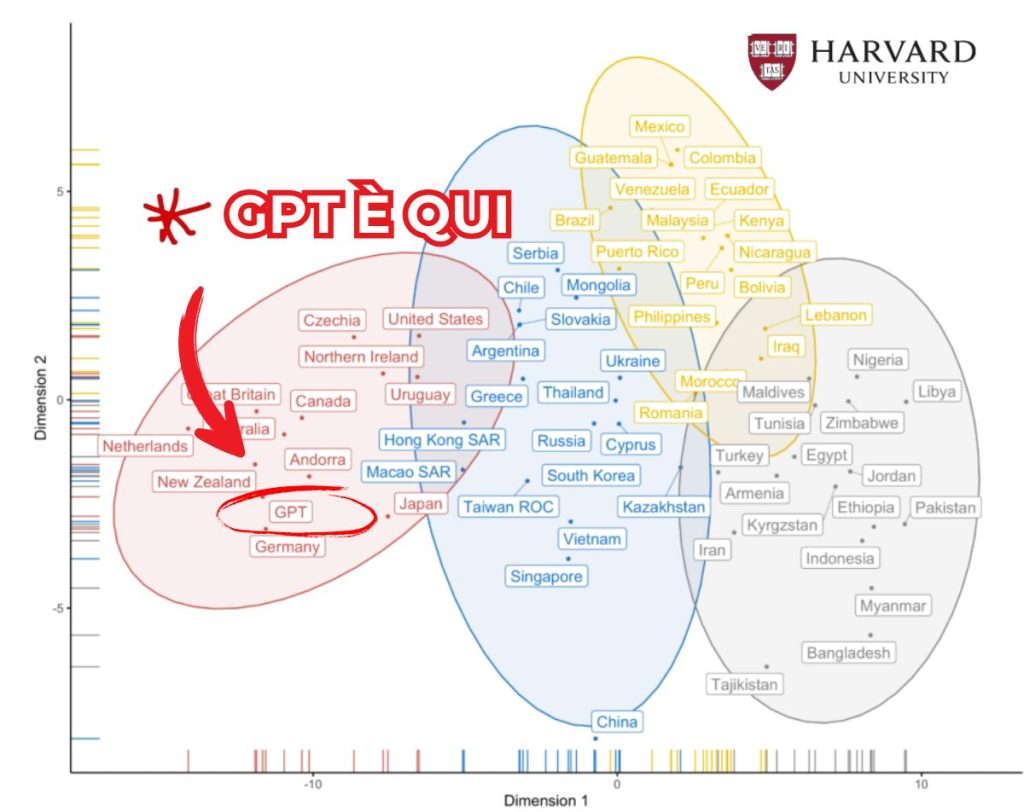

Ci pensa Harvard con un illuminante paper che smaschera un grande difetto di ChatGPT: nonostante sia disponibile in tutto il mondo, sa “pensare” solamente come un occidentale, istruito, industrializzato, ricco e democratico. Tante AI come il chatbot di OpenAI sono infatti culturalmente sbilanciate: pensano, giudicano e rispondono come chi le ha addestrate, direttamente da un bel laboratorio iper-tecnologico immerso nella Silicon Valley.

Cerchiamo di spiegarci meglio con un dato: ChatGPT “capisce” gli americani al 70%. E se un utente non fosse statunitense ma, ad esempio… etiope? La percentuale crollerebbe al 12%.

Quell’AI che ci sembra tanto “umana”, troppo umana… di fatto è tutt’altro che universale: rappresenta meno del 15% della popolazione mondiale. Assomiglia più che altro, nelle parole di Matteo Arnaboldi, ad un “programmatore californiano, ad un cittadino europeo istruito o ad una minoranza che, pur essendo tecnologicamente dominante, rappresenta solo una piccola frazione dell’umanità reale”.

Punto di non ritorno, o di nuova partenza?

C’è una scena in Blade Runner in cui il replicante Roy Batty (Rutger Hauer), nei suoi ultimi attimi di vita, dice a Rick Deckard (Harrison Ford), il suo creatore: “Ho visto cose che voi umani non potreste immaginarvi.” È il momento in cui la creatura supera il creatore in esperienza, in profondità, in vita vissuta. Ma è anche una bugia bellissima, perché Roy non ha “visto” niente. Ha simulato di vedere, con memorie impiantate da altri.

La domanda non è più quindi se l’AI diventerà troppo umana. La domanda è: stiamo diventando noi troppo artificiali? Quando un adolescente italiano preferisce confidarsi con ChatGPT piuttosto che con un amico, quando 119.000 italiani passano 20 ore al mese parlando con Character.AI, quando il 20% della Gen Z usa un chatbot come sostituto della terapia (Ok Salute), cosa stiamo ottenendo? Efficienza? Accessibilità? O stiamo solo rendendo più sopportabile una solitudine strutturale che non vogliamo affrontare?

Noi qui, in questa sede, non vogliamo fornire risposte. Ci limitiamo a presentarvi i dati. E i dati dicono che tra dieci anni, forse meno, non avremo più questa “conversazione”. Perché l’avremo già delegata a un’AI più brava di noi a scrivere articoli che sembrano profondi, ma non dicono niente di nuovo.

O forse ci riapproprieremo dei valori che ci rendono intrinsecamente umani. Forse scopriremo che la vera intelligenza non è quella che risponde sempre “sì”. È quella che sa quando tacere, quando dire “non lo so”, quando ammettere che alcune domande non hanno risposte facili. O non hanno proprio risposte.

E quindi, dove sta la verità?

Boh, noi non ne sappiamo nulla.

Ciao, chatbot. A presto.