Vi è mai capitato di scorrere Facebook e imbattervi in una foto che vi ha fatto pensare “ma che cos’è questa roba?“. Se la risposta è sì, non siete i soli. E probabilmente, quella sensazione di stranezza che avete provato era più che giustificata. Se la risposta è ancora no, siete fortunati. Ma vi consigliamo di leggere questo articolo, per essere pronti quando succederà (perché sì, purtroppo, succederà).

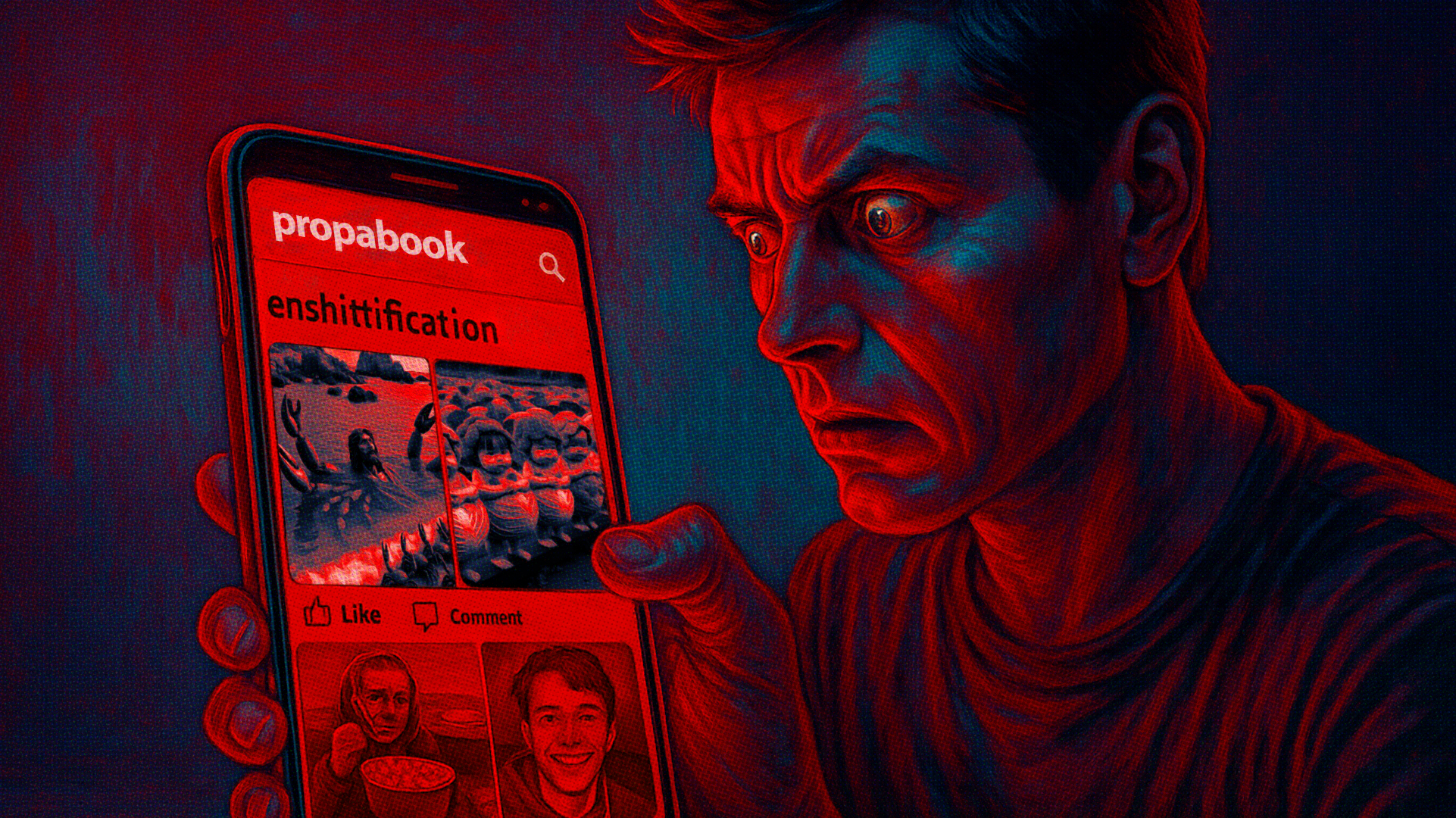

Siamo nel pieno di quello che gli esperti chiamano “enshittification” – un processo attraverso cui le piattaforme digitali peggiorano gradualmente la qualità dei loro servizi in nome del profitto. E se pensavate che Facebook avesse già toccato il fondo, beh… preparatevi a ricredervi. L’ultimo capitolo di questa degenerazione si chiama AI slop, e negli ultimi mesi sta invadendo i nostri feed con contenuti falsi, truffe e manipolazioni sempre più sofisticate.

Ma cosa succede quando l’intelligenza artificiale diventa il perfetto complice delle truffe online? E perché Meta sembra fare così poco per fermare questo fenomeno?

Cos’è l’enshittification e perché dovrebbe interessarci

Il termine “enshittification” – che potremmo tradurre in maniera un po’ brutale con “merd-izzazione” – è stato coniato dal blogger e attivista digitale canadese Cory Doctorow per descrivere un processo preciso e ripetuto. 1) Le piattaforme digitali iniziano offrendo un servizio eccellente agli utenti; 2) gradualmente peggiorano l’esperienza per favorire gli inserzionisti; 3) infine spremono anche gli inserzionisti per massimizzare i profitti aziendali.

Il termine ha guadagnato una tale rilevanza che il Macquarie Dictionary – il principale dizionario australiano – lo ha scelto come parola dell’anno 2024, riconoscendo un fenomeno che molti di noi avevano già percepito, pur senza riuscire a dargli un nome.

Facebook rappresenta forse il caso di studio più evidente di enshittification. Ricordate quando vi mostrava principalmente i post dei vostri amici e familiari? Quei tempi sono un ricordo lontano. Secondo uno studio di Harvard, dal secondo trimestre del 2021 al terzo trimestre del 2023, la porzione di contenuti nel Feed provenienti da “post non connessi” (ovvero da pagine e profili che gli utenti non seguono) è salita dall’8% al 24%. Che da un lato, può sembrare un aspetto positivo: la possibilità di scoprire contenuti di nostro interesse è – o almeno dovrebbe essere – il motivo di questo cambio di paradigma.

Ma c’è un problema: gli ultimi aggiornamenti dell’algoritmo di Facebook, progettati per competere con TikTok e spingere contenuti considerati “coinvolgenti”, hanno aperto le porte a qualcosa di molto più sospetto.

AI Slop: la nuova frontiera del contenuto spazzatura

“AI Slop” – termine che potremmo tradurre come “poltiglia di intelligenza artificiale” – identifica quella massa di contenuti di bassa qualità generati artificialmente che sta invadendo i social media, e Facebook in particolare. Si tratta di immagini, testi e video creati con strumenti di intelligenza artificiale, spesso ovviamente falsi e totalmente privi di senso, ma stranamente efficaci nel catturare l’attenzione – esattamente come i contenuti “brain rot”, a sua volta Parola dell’anno 2024 ma secondo il dizionario britannico, l’Oxford Dictionary, del quale abbiamo parlato in questo articolo.

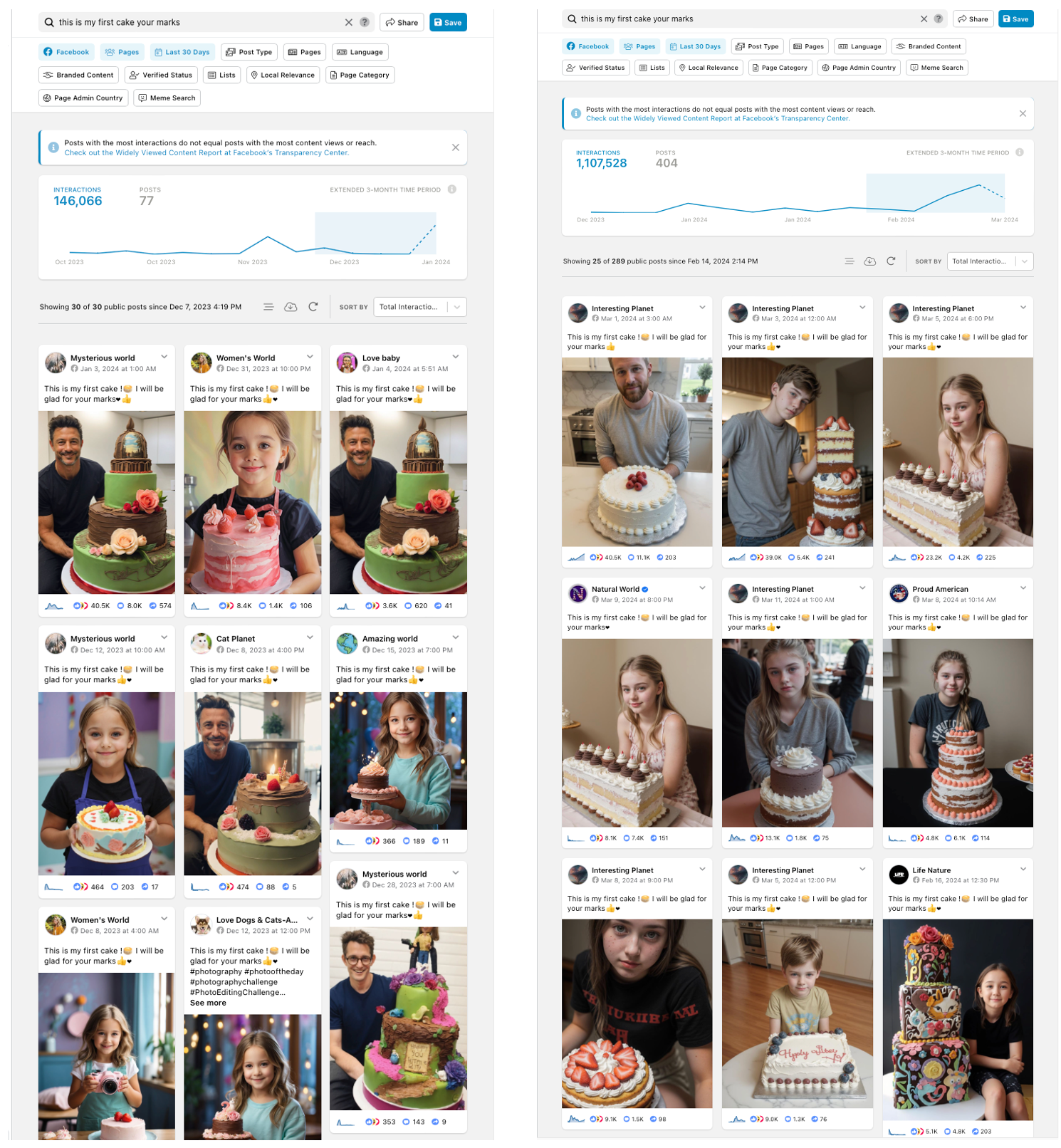

Il fenomeno dell’AI Slop è ormai talmente diffuso che anche voi potreste averlo incontrato senza rendervene conto. Avete mai visto per caso su Facebook alcune immagini di:

- Anziani o bambini con torte di compleanno e didascalie come This is my first cake! I will be glad for your marks (“Questa è la mia prima torta! Sarò grato/a per i vostri complimenti”)

- Persone che mostrano presunti lavori di falegnameria – o pittura, o scultura – con la scritta Made it with my own hands (“L’ho fatto con le mie mani”)

Un semplice post dell’account “Leandro Cañete” su Facebook. Più di 16.000 reazioni, quasi 1.700 commenti e 500 condivisioni.

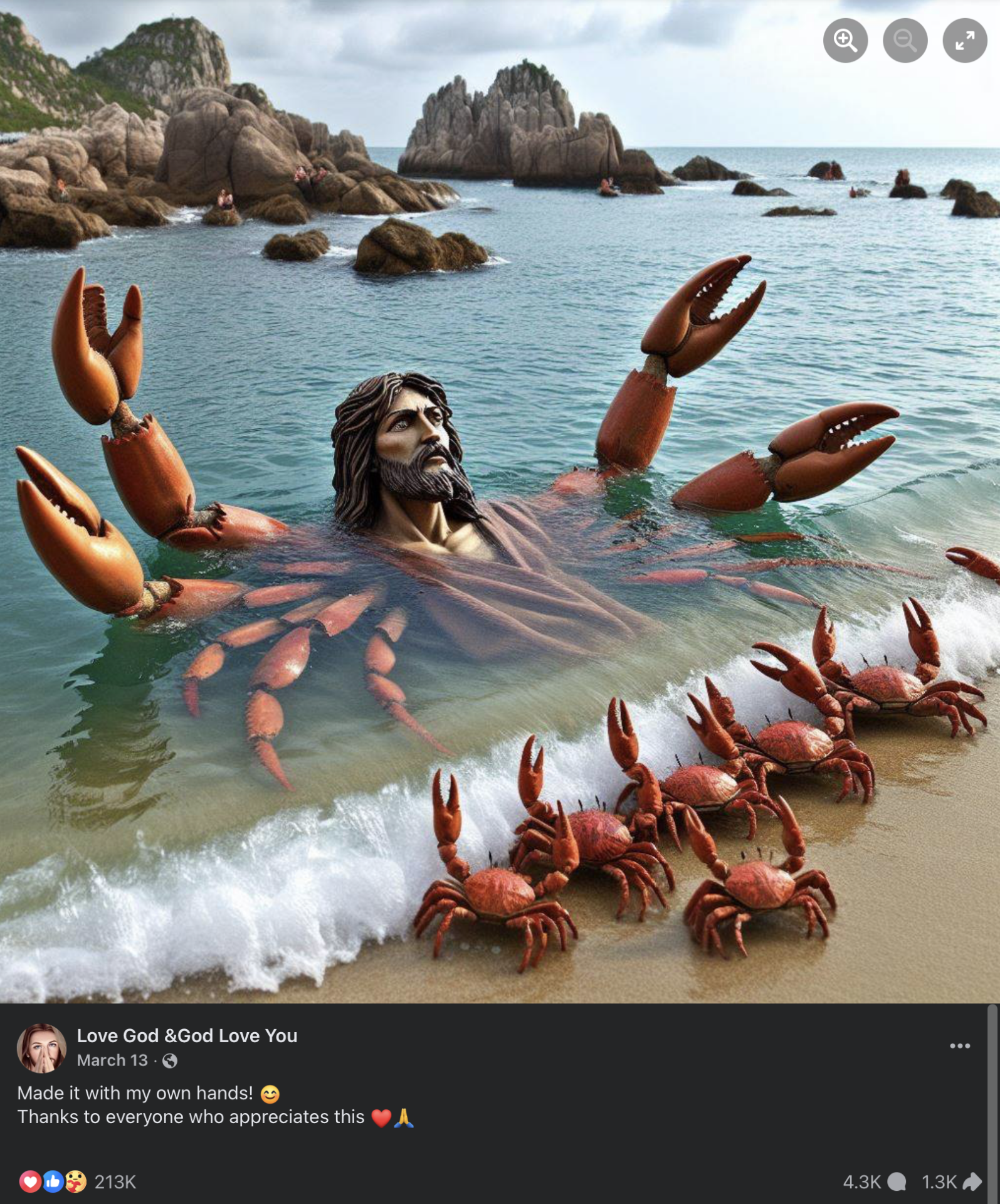

- Strane rappresentazioni parecchio blasfeme di Gesù fatto di gamberetti o granchi (sì, avete letto bene. Parliamo proprio di Shrimp Jesus AKA Crab Jesus)

Immagine pubblicata dal gruppo Facebook “Love God &God Love You”. Un Gesù venerato da granchi… Duecentotredicimila reazioni.

- Animali “sporchi” che vengono ripresi mentre vengono “puliti” da anonimi benefattori – casualmente sempre dotati di videocamere in 4k – che evidentemente hanno tanto tempo da dedicare alla cura di queste creature (grazie ragazzi!). “Su dai, abbiamo trovato per strada un povero riccio indifeso, puliamolo dalle sue scorie!” (Instagram). “E poi, visto che ci troviamo improvvisamente al Circolo Polare Artico, perché non prenderci cura di un bianchissimo orso polare?” (Instagram)

Ecco, questi sono classici esempi di AI Slop. Contenuti che spesso utilizzano le stesse frasi copiate e incollate tra diverse pagine e riciclano all’infinito la stessa tipologia di contenuti. Eppure, funzionano. E quindi perché no… ci proviamo anche noi!

(immagine Tadde che dice “ho scritto un articolo ma nessuno l’ha letto”)

Come riconoscere le truffe AI su Facebook

Distinguere un contenuto autentico da uno generato artificialmente sta diventando sempre più difficile, ma esistono ancora alcuni segnali (le cosiddette “red flag”) che possono aiutarci:

Errori anatomici più o meno evidenti

Le immagini AI spesso presentano errori grossolani: mentre ormai l’AI si è evoluta e non si vedono più persone con tre mani o sei dita come succedeva l’anno scorso, degli errori sono ancora visibili. A volte l’intelligenza artificiale fatica ancora a gestire correttamente l’anatomia umana, e può capitare di vedere persone che piegano il gomito in modi strani, o non hanno i piedi ben poggiati a terra, o altri dettagli simili.

Volti sfocati o indefiniti

Le persone nelle immagini AI-generate spesso hanno lineamenti sfocati e indefiniti, che sembrano dissolversi nel paesaggio circostante.

Didascalie ripetitive e generiche

Se vedete la stessa frase emotiva ripetuta su decine di post diversi, è probabile che si tratti di contenuto automatizzato. I truffatori usano spesso formule che funzionano per generare engagement.

Crescita follower sospetta

Molte pagine mostrano improvvisi picchi di follower dopo aver cambiato nome e iniziato a pubblicare contenuti AI. Ad esempio, una pagina è passata da 9.400 follower come band musicale a 300.000 follower in una settimana dopo essere diventata “Life Nature”.

Il business model delle truffe: perché Meta non interviene?

Qui arriva il punto più inquietante della questione. Ci aiuta nella ricerca sempre lo studio di Harvard, nel quale gli studenti hanno scoperto che 120 pagine Facebook che pubblicavano frequentemente immagini generate con l’AI hanno ottenuto “centinaia di milioni di engagement ed esposizioni“. Nel terzo trimestre del 2023, uno dei 20 post più visti su Facebook era un’immagine AI-generata con 40 milioni di visualizzazioni, pubblicata dall’account “Cafehailee”, che peraltro NON aveva indicato il contenuto come generato dall’AI.

L’immagine, ora non più disponibile, pubblicata dall’account “Cafehailee“. L’account esiste ancora e ad oggi ha 350.000 follower.

Il problema è che questo sistema porta profitti astronomici. Secondo alcune investigazioni giornalistiche, una porzione significativa del fatturato pubblicitario di Facebook deriverebbe proprio da queste attività truffaldine – le cosiddette “scam” che prosperano anche grazie all’AI slop.

I creator di spam possono guadagnare migliaia di dollari al mese pubblicando contenuti AI su Facebook, sfruttando i “bonus prestazione” che la piattaforma paga per i contenuti pubblici (possibilità in corso fino al 31 agosto 2025). Non sorprende quindi che esistano decine di tutorial su YouTube che insegnano proprio come monetizzare questo tipo di contenuti, come analizzato ampiamente sempre dall’autore Cory Doctorow in un suo recente talk.

I goffi tentativi di Meta di arginare il fenomeno

Nell’aprile 2025, Meta ha finalmente riconosciuto il problema pubblicando un comunicato intitolato “Cracking Down on Spammy Content on Facebook“. L’azienda ha annunciato una serie di misure: limitare la reach degli account che pubblicano contenuti spam, rimuovere le reti di account fake, e proteggere i creator originali.

Ma cosa significa concretamente? Meta ha promesso di ridurre la visibilità degli account che pubblicano contenuti con “didascalie lunghe e distraenti, spesso con una quantità eccessiva di hashtag” o didascalie completamente non correlate al contenuto. Nel 2024, hanno rimosso oltre 100 milioni di pagine fake che gonfiavano artificialmente la loro reach.

Un numero impressionante, vero? Vero. Ma il problema è che il fenomeno è tutt’altro che arginato. Dopo aver iniziato a investigare su questo tema – allenando quindi indirettamente il proprio algoritmo – molti giornalisti hanno notato come i loro feed Facebook siano stati invasi da AI slop, suggerendo che questo tipo di contenuti continuano ad essere proposti e valorizzati.

Il paradosso dell’engagement: quando il fake funziona meglio del vero

C’è un aspetto particolarmente preoccupante in tutto questo: molti utenti sembrano non riconoscere che le immagini sono generate artificialmente, commentando e reagendo come se fossero contenuti autentici. Congratulazioni a bambini non reali per i loro dipinti AI, espressioni di solidarietà verso anziani che non esistono, commenti entusiasti su torte mai cucinate… e la lista è lunga.

Alcuni utenti più accorti hanno iniziato a sviluppare una sorta di “resistenza” organica, pubblicando commenti di avvertimento e condividendo infografiche che spiegano come riconoscere i contenuti AI. Ma per il momento, sono ancora una minoranza. Questo crea un paradosso inquietante: i contenuti falsi generano più engagement di quelli veri, alimentando un circolo vizioso dove l’algoritmo continua a premiarli.

Inoltre l’AI slop non è un problema limitato a Facebook. Si sta diffondendo su LinkedIn, Instagram, TikTok e praticamente ogni piattaforma social. Anche se Facebook rimane il terreno più fertile per questo tipo di manipolazione, probabilmente per la sua demografia più anziana e digitalmente meno esperta.

Cosa possiamo fare per difenderci

Di fronte a questo scenario, l’informazione diventa la nostra arma più potente. Anche in questo caso, la soluzione passa attraverso un uso più critico e consapevole dei social media.

Alcuni consigli utili e pratici:

- Verificate sempre la fonte dei contenuti che condividete

- Fate attenzione alle immagini troppo “perfette” o con effetti realistici

- Diffidate dalle pagine con crescite di follower improvvise e sospette

- Segnalate i contenuti palesemente falsi o truffaldini

- Condividete queste informazioni costruttive con amici e familiari, in particolare quelli “meno esperti” digitalmente

Una riflessione sul futuro della comunicazione digitale

Mentre scriviamo questo articolo, ci rendiamo conto di trovarci di fronte a un bivio cruciale per il futuro della comunicazione digitale. L’enshittification non è solo un processo tecnico, ma un vero e proprio sintomo della piega che stanno prendendo i social media negli ultimi anni.

L’AI slop rappresenta forse l’evoluzione più preoccupante di questo fenomeno: non solo i nostri dati vengono estratti e venduti, ma ora anche la nostra attenzione viene catturata attraverso contenuti completamente artificiali, progettati unicamente per generare profitti. La domanda che dovremmo porci non è se riusciremo a fermare questo fenomeno – probabilmente è già troppo tardi per quello – ma se saremo in grado di sviluppare gli anticorpi culturali necessari per navigare in un mondo dove la distinzione tra vero e falso diventa sempre più sfumata.

Perché alla fine – come spesso accade per le innovazioni tecnologiche – il vero problema non è l’intelligenza artificiale in sé, ma l’uso che ne facciamo. E finché considereremo l’engagement più importante della verità, continueremo a nutrire questo nemico digitale che divora la nostra capacità critica e cognitiva.

Se questo articolo vi è stato utile, condividetelo con amici e familiari: l’informazione resta la nostra migliore difesa contro l’enshittification del web. E ricordate: in un mondo pieno di AI slop, ogni contenuto umano autentico diventa un atto di resistenza.